«Stai guardando un cheeseburger su un piatto», dice la voce dal telefonino. La donna resta senza parole, attonita, prima che l’emozione la faccia esplodere in un incontenibile «Oh, mio Dio».

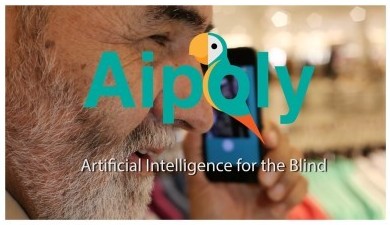

Ha appena provato un’applicazione in grado, se non proprio di ridarle la vista, almeno di far lavorare la sua sconfinata e allenatissima immaginazione fornendogli un’idea piuttosto precisa di ciò che ha di fronte. «Aipoly», l’ultima evoluzione di quella che viene definita la «visione artificiale», a novembre sarà disponibile in applestore. Da ottobre sarà possibile usare la versione beta, quella di prova, iscrivendosi già da ora al sito aipoly.com. Come funziona? Si fa una foto e al massimo in una ventina di secondi il cellulare descrive l’immagine.

Semplice? Solo in apparenza

Dopo il clic il programma trasmette via Internet la fotografia a un server, che confronta con altri milioni di immagini di tutti i tipi relative a oltre 300 mila oggetti diversi e, quando trova quella che le corrisponde, manda la risposta.

L’idea è venuta a due giovanissimi startupper, l’australiana 26enne Marita Cheng, premiata come giovane dell’anno 2012 nel suo Paese, e il 22enne italiano Alberto Rizzoli. Figlio dell’ex editore del Corriere della Sera Angelo, morto nel 2013, e di Melania De Nichilo Rizzoli, ex deputato di Forza Italia, ora responsabile sanità del partito, Alberto si è laureato in gestione aziendale a Londra prima di approdare a Mountain View (California) grazie a un finanziamento da 30 mila euro dato da Google per sviluppare Aipoly nella Singularity University. È un istituto sponsorizzato dal gigante di Internet che seleziona giovani imprenditori da tutto il mondo con l’obiettivo ambizioso di assisterli in progetti che potrebbero migliorare la vita di un miliardo di persone entro dieci anni. Singularity è stata fondata nel 2008 da Raymond Kurzweil, 67 anni, pioniere nel riconoscimento ottico dei caratteri e nelle tecnologie per ipovedenti.

Come è nato Aipoly?

«Eravamo a Google e un ingegnere ci parlava dei problemi legati alla capacità di vedere di auto e robot e dei problemi che hanno nel riconoscere il mondo fisico», racconta Rizzoli. Uno dei limiti di queste macchine, infatti, è che di fronte a un bambino e a un cono stradale che non possono evitare, non sanno ancora distinguere quale dei due è meglio investire. «Poi abbiamo assistito alla dimostrazione di un sistema in grado di fare una narrazione semantica, cioè di contestualizzare autonomamente frasi e parole. Abbiamo pensato a come applicare le due cose», aggiunge. Aipoly analizza, riconosce e descrive le figure e la loro posizione, colori, ruolo e azioni, ad esempio se una persona sta correndo o sorridendo. In pochi secondi, chi non vede può, ad esempio, sapere quello che stanno indossando i suoi figli, riconoscere cartelli stradali, oggetti fuori portata, il prezzo di un vestito. Tutto senza l’assistenza di altre persone».

Steve Mahan, che presiede il centro per non vedenti di Santa Clara (California), il primo a testare le auto di Google che si guidano da sole, di Aipoly apprezza «l’aiuto che dà a costruire un’immagine mentale, perché solo alcuni ciechi sono capaci di formulare tali immagini». Per migliorare le prestazioni dell’applicazione è necessario aggiungere sempre più immagini al database, cosa demandata a un gruppo di programmatori. «Abbiamo fatto provare l’applicazione a 88 non vedenti e ne sono stati entusiasti. Ci sono 285 milioni di persone nel mondo come loro ed entro il 2020 uno su tre utilizzerà uno smartphone», considera Rizzoli, l’imprenditore.